3D注意事项 Sanghyun Woo, et al. "CBAM: Convolutional Block Attention Module." arXiv preprint arXiv:1807.06521v2 (2018). 代码: class channel_attention ( tf . keras . layers . Layer ): """ channel...

”attention-model 3d-attention spatial-attention cbam channel-attention position-attention Python“ 的搜索结果

TensorFlow版本:1.9.0 Keras版本:2.0.2 我的博客: :

基于mindspore框架实现的Unet++、attention-Unet等算法python源码.zip基于mindspore框架实现的Unet++、attention-Unet等算法python源码.zip基于mindspore框架实现的Unet++、attention-Unet等算法python源码.zip基于...

摘要 对于极大规模文本分类问题,传统方法主要是采用bag_of_words方法,该方法忽略了词的上下文... 提出了multi-label attention mechanism,该机制能捕获和每个标签最相关的部分,即对于不同的标签有不同的文本表示。

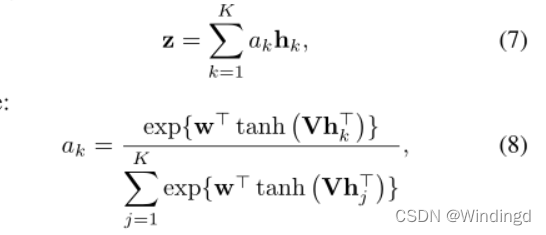

论文及源码解读:Attention-Based Bidirectional Long Short-Term Memory Networks for Relation Classification 在基于深度学习的知识图谱构建过程中,知识抽取环节中的实体关系抽取至关作用。本博文将解读2016...

本文主要介绍了大模型加速库flash-attention的安装教程,希望能对使用flash-attention的同学们有所帮助。 文章目录 1. 背景描述 2. 逐步安装教程

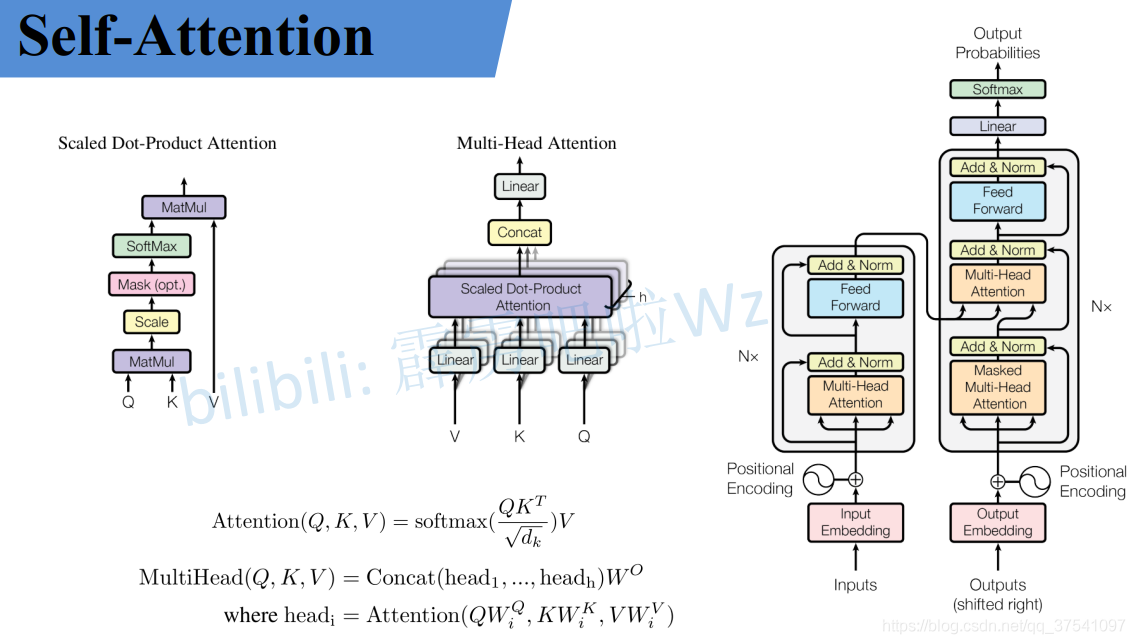

Self-Attention自注意力机制是Transformer模块的重要组成部分,是截至到现在(2024年1月6日)大大小小网络的标配,无论是LLM还是StableDiffusion,内部都有Self-Attention与Transformer,因此,一起来学学哈哈。

【AAAI 2021】基于Attention的知识蒸馏:Knowledge Distillation via Attention-based Feature Matching论文地址:代码地址:主要问题:主要思路:具体实现:实验结果: 论文地址: ...代码地址: ...

U-net 原理部分之前的博客有些了,这里主要记录一下代码实现U-net往期博客:https://blog.csdn.net/qq_19841133/article/details/126927383基于Attention-based(用的是自注意力机制)的U-net。

Attention-over-Attention模型(AOA Reader模型)是科大讯飞和哈工大在2017ACL会议上的《Attention-over-Attention Neural Networks for Reading Comprehension》(论文地址)联合提出的。科大讯飞和哈工大在2016ACL...

checkbox的样式方案1:css3自定义checkbox,IE9不兼容html:<div class="col-xs-12" > <label for="chk" class="chkbox" ng-class="...span clas

论文来自北京大学计算机科学技术研究所多媒体信息处理研究室...论文下载:Object-Part Attention Model for Fine-grained Image Classification 知乎专栏计算机视觉一隅,文章TIP 2018 Object-Part Attent...

分类预测 | MATLAB实现CNN-LSTM-Attention多输入分类预测

1 Self-Attention的概念2 Self-Attention的原理3 Self-Attention的作用4 Self-Attention的问题。

推荐文章

- 机器学习之超参数优化 - 网格优化方法(随机网格搜索)_网格搜索参数优化-程序员宅基地

- Lumina网络进入SDN市场-程序员宅基地

- python引用传递的区别_php传值引用的区别-程序员宅基地

- 《TCP/IP详解 卷2》 笔记: 简介_tcpip详解卷二有必要看吗-程序员宅基地

- 饺子播放器Jzvd使用过程中遇到的问题汇总-程序员宅基地

- python- flask current_app详解,与 current_app._get_current_object()的区别以及异步发送邮件实例-程序员宅基地

- 堪比ps的mac修图软件 Pixelmator Pro 2.0.6中文版 支持Silicon M1_pixelmator堆栈-程序员宅基地

- 「USACO2015」 最大流 - 树上差分_usaco 差分-程序员宅基地

- Leetcode #315: 计算右侧小于当前元素的个数_找元素右边比他小的数字-程序员宅基地

- HTTP图解读书笔记(第六章 HTTP首部)响应首部字段_web响应的首部内容-程序员宅基地